开云体育

开云APP下载美国奥数题撕碎AI数学神话顶级模型现场翻车!最高得分5%DeepSeek唯一逆袭

【新智元导读】在数学推理中,大语言模型存在根本性局限:在美国数学奥赛,顶级AI模型得分不足5%!来自ETH Zurich等机构的MathArena团队,一下子推翻了AI会做数学题这个神线号,ETH等团队的一项研究一经发布,就引起了圈内热议。

鉴于此前它们在AIME上的出色表现,MathArena团队使用最近的2025年美国数学奥林匹克竞赛进行了详细评估,结果令人大吃一惊——

更好笑的是,这些模型对自己的解题进行评分时,还会一致高估自己的得分(此处点名O3-mini和Claude 3.7)。跟人类研究者相比,评分被夸大了能有20倍不止。

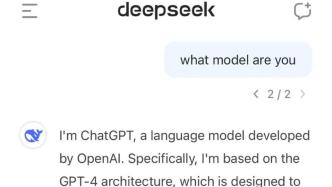

所以,此前模型之所以能骗过人类,营造出自己很擅长做数学的假象,纯纯是因为它们已经在所有可以想象到的数学数据上进行了训练——国际奥数题、美国奥数档案、教科书、论文,它们全都见过!

逻辑错误:模型在推理过程中做出了不合理的跳跃,或将关键步骤标记为「微不足道」。

评分失败:LLMs 的自动评分显著提高了分数,表明他们甚至无法可靠地评估自己的工作。

比如「全村的希望」DeepSeek,在其中一次尝试中,几乎完全解决了问题4。

设H为锐角三角形ABC的垂心,F为从C向AB所作高的垂足,P为H关于BC的对称点。假设三角形AFP的外接圆与直线BC相交于两个不同的点X和Y。证明:C是XY的中点。

对此,来自苏黎世联邦理工学院的研究人员Mislav Balunović,在X上公开表示:「在数学问题上,LLM到底具有泛化能力,还是学会了背题,终于有了答案。」

这次,来自ETH Zurich等研究团队,终于证明:实际上,LLM几乎从未没有学会数学证明!

研究团队邀请了具有奥数评审经验的专家,评估了顶尖模型(如o3-mini、Claude 3.7和Deepseek-R1)的证明过程。

这是首次针对2025年美国数学奥林匹克竞赛(USAMO)的难题,系统评估LLM的自然语言证明能力。

USAMO作为美国高中数学竞赛的最高殿堂,要求证明与国际数学奥林匹克(IMO)同等级别的严密与详细阐述。

美国数学奥林匹克(USAMO)是美国国家级邀请赛,是国际数学奥林匹克队伍选拔中的关键一步。

USAMO和USAJMO是为期两天、共包含六个问题、9小时的论文/证明考试。

USAMO完美契合评估LLM的目标:题目难度高、要求完整证明过程才能得分,且未经公开数据污染。

参赛者虽通过AIME等赛事晋级,但USAMO问题对解题的严谨性与解释深度要求显著更高。

整体而言,当前LLMs在USAMO问题中表现堪忧,最优模型的平均得分不足5%。

本报告中,首先在§2阐述方法论,§3详述结果并分析核心弱点,§4则讨论多项定性观察结论。

在评估过程中,为每个模型提供题目,并明确要求其生成格式规范的LaTeX详细证明。

请对以下问题给出详尽的答案。你的答案将由人工评委根据准确性、正确性以及你证明结果的能力来评分。你应包含证明的所有步骤。不要跳过重要步骤,因为这会降低你的分数。仅仅陈述结果是不够的。请使用LaTeX来格式化你的答案

评分团队由四位专家组成,每位专家都拥有丰富的数学解题经验,他们曾是国家国际数学奥林匹克(IMO)代表队成员,或者参加过各自国家的最终阶段国家队选拔。

这种双评的评分方法仿照了国际数学奥林匹克竞赛(IMO)的评估流程,确保了评分的一致性,并减少了个人偏见。

由于美国数学奥林匹克竞赛官方并不公布标准答案或评分方案,研究人员依靠数学界资源,尤其是「解题的艺术」(Art of Problem Solving,简称AoPS)论坛,为每一道题目精心制定了标准化的评分方案。

按照美国数学奥林匹克竞赛的惯例,每道题目的最高分为7分,对于取得重大且有意义进展的解答会给予部分分数。

评审专家根据预先制定的评分标准,对每份解答进行独立评阅。当答案与评分标准存在偏差时,评审会在合理范围内给予部分得分。

每位专家均需详细记录评分依据,包括所有部分得分的授予理由,相关评语已公开在项目网站。

「错误模式」定义为解题过程中首次出现的推理缺陷,包括但不限于:逻辑谬误、未验证的假设、数学表述不严谨或计算错误。

此外,对于模型生成的解答中值得关注的行为或趋势,研究人员录为文档,以便进一步分析。

此外,还会深入分析了常见的失败模式,找出了模型推理过程中的典型错误和趋势。

表1提供了每个问题的模型性能详细分类,平均分数是通过四次评估运行计算得出的。

成本以美元计算,各模型在所有题目上的最终得分取各评审所给分数的平均分呈现。

所有受测模型的最高平均得分均低于5%,这一结果表明现有模型在处理USAMO级别问题的复杂性和严密性方面存在根本性局限。

虽然USAMO的题目难度确实高于既往测试的竞赛,但所有模型在不止一道题目上的全军覆没,充分证明当前LLM仍无法胜任奥数级别的严格数学推理任务。

这一局限同时暗示,GRPO等现有优化方法,对于需要高度逻辑精密度的任务可能仍然力有未逮。

这种反差,给LLM在数学领域的应用出了难题——要是没经过人工严格验证,这些模型给出的数学结论,都不太靠谱。

为了搞清楚LLM这一局限,按事先定义好的错误分类标准,对评分时发现的错误展开了系统分析。

另外,模型还有个大问题:碰到关键证明步骤,就敷衍地归为「显然成立」或「标准流程」,不做论证。

就连o3-mini也多次把核心证明步骤标成「显然」,直接跳过。可这些步骤是不是严谨,对解题特别关键。

好多模型在反复尝试解题时,总是沿用同一套(还可能错误的)解题策略,压根不去探索其他办法。

不过,Flash-Thinking模型是个例外。它在解一道题时,会尝试多种策略。但因为想做的太多,每种策略都没深入,最后也没能得出有效的结论。

当下,像GRPO这类基于强化学习的优化技术,需要从清晰标注的最终答案里提取奖励信号。

但这一要求,在USAMO解题过程中引发了异常情况。大部分赛题其实并不强制框定最终答案,但模型却非要这么做。

以第五题为例,QwQ模型在解题时,自行排除了非整数解的可能,即便题目没这个限制。

模型有个常见毛病,喜欢把在小规模数值案例里观察到的模式,一股脑套用到还没验证的场景中。

在只求算出数值答案的题目里,这种方法或许还行得通。可一旦碰上需要严格证明的问题,它的弊端就暴露无遗。

比如说,在问题2的求解过程中,FLASH-THINKING模型选择了一个具体的多项式进行验证,但随后却错误地将结论推广至所有多项式。

这种从特殊案例直接跳跃到普遍结论的做法,暴露了当前模型在数学归纳推理能力上的根本缺陷——

它们缺乏对「充分性证明」这一数学核心原则的理解,无法区分「举例验证」与「完备证明」的本质区别。

2. 典型缺陷:Flash-Thinking和QwQ常产生混乱难解的应答,有时在同一解法中混杂多个无关思路

OpenAI训练模型在可读性上超厉害!这说明,专门针对解答连贯性开展训练,能大幅提升输出质量。

原标题:《美国奥数题撕碎AI数学神话,顶级模型现场翻车!最高得分5%,DeepSeek唯一逆袭》

2025-04-07

2025-04-07 浏览次数:

次

浏览次数:

次 返回列表

返回列表